在信息技術飛速發展的今天,我們正身處一個被數據定義的時代。從社交媒體互動、電子商務交易,到物聯網傳感器讀數、科學研究模擬,海量數據以前所未有的速度和規模產生與積累,構成了我們所說的“大數據”。這些原始數據本身價值有限,唯有經過高效、精準的處理,才能轉化為洞察、決策和創新的源泉。本文將探討大數據處理的核心概念、關鍵技術、應用場景以及面臨的挑戰。

一、大數據處理的核心特征

大數據通常以“5V”特性被定義:

- 體量(Volume):數據規模巨大,常以TB、PB乃至EB計,遠超傳統數據庫的處理能力。

- 速度(Velocity):數據生成、流動和處理的速度極快,往往要求實時或近實時響應,如金融交易或在線推薦。

- 多樣性(Variety):數據來源和格式多樣,包括結構化數據(如數據庫表)、半結構化數據(如XML、JSON日志)和非結構化數據(如文本、圖像、視頻、音頻)。

- 真實性(Veracity):數據的質量和可信度不一,存在噪聲、不完整和不一致等問題,處理時需進行清洗和驗證。

- 價值(Value):這是最終目標,即從龐雜數據中提取出高價值、可操作的洞察。

數據處理正是圍繞這“5V”展開,旨在克服規模、速度和復雜性帶來的障礙,最終實現數據價值的最大化。

二、大數據處理的關鍵技術棧

為了應對上述挑戰,一系列創新技術和架構應運而生:

- 分布式存儲與計算框架:這是處理海量數據的基石。以Hadoop和Spark為代表的生態系統,通過將數據和計算任務分布到成百上千臺廉價服務器集群中,實現了水平擴展和并行處理。HDFS提供可靠的分布式存儲,而MapReduce、Spark等計算框架則高效執行批處理和復雜分析任務。

- 流處理技術:針對高速數據流,如Flink、Apache Storm、Spark Streaming等系統,能夠以極低的延遲對連續到達的數據進行實時處理、聚合和分析,滿足欺詐檢測、實時監控等場景的需求。

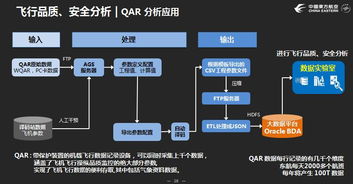

- 數據集成與ETL:將來自不同源頭、格式各異的數據進行提取、轉換和加載(ETL),整合到統一的數據倉庫或數據湖中,為分析做準備。現代工具如Apache NiFi、Talend等提供了可視化和可擴展的解決方案。

- 數據管理與數據庫技術:傳統關系型數據庫難以應對大數據場景,因此NoSQL數據庫(如MongoDB、Cassandra、HBase)和NewSQL數據庫興起,它們在可擴展性、靈活性和性能上各有側重,以支持不同的數據模型和訪問模式。數據湖架構則允許以原生格式存儲各種類型的數據。

- 數據分析與機器學習:數據處理的高級階段。通過SQL-on-Hadoop工具(如Hive、Impala)、數據挖掘算法和機器學習平臺(如TensorFlow、PyTorch與大數據框架的集成),進行探索性分析、模式識別和預測建模。

- 數據治理與安全:隨著數據規模和重要性的提升,確保數據質量、元數據管理、隱私保護(如差分隱私、聯邦學習)和訪問安全變得至關重要。

三、大數據處理的應用場景

高效的數據處理能力已滲透到各行各業:

- 商業智能與決策:企業通過分析客戶行為、銷售數據和市場趨勢,優化運營、精準營銷和戰略規劃。

- 智慧城市:處理交通流量、環境傳感器和公共安全數據,以改善城市規劃、交通管理和應急響應。

- 醫療健康:分析基因組學數據、電子病歷和醫療影像,助力疾病預測、個性化治療和新藥研發。

- 金融服務:實時處理交易數據,用于風險控制、欺詐偵測和算法交易。

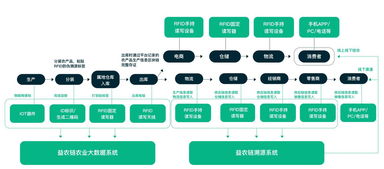

- 工業物聯網:監控生產線設備數據,實現預測性維護,提升制造效率和質量。

四、挑戰與未來展望

盡管技術不斷進步,大數據處理仍面臨諸多挑戰:

- 技術與人才壁壘:生態系統復雜,工具迭代快,需要兼具領域知識和技術專長的復合型人才。

- 成本與復雜性:構建和維護大規模集群成本高昂,系統集成和管理復雜度高。

- 數據隱私與倫理:如何在挖掘價值的嚴格遵守數據保護法規(如GDPR),防止隱私泄露和算法偏見,是亟待解決的倫理與社會問題。

- 從“大數據”到“好數據”:數據的價值密度可能很低,需要更智能的方法從海量數據中快速定位高價值信息。

大數據處理技術正朝著更智能、更自動化、更融合的方向發展。云原生數據處理服務降低了使用門檻;AI與數據處理的深度結合,使得數據處理管道本身更加智能和自適應;邊緣計算的興起,將部分處理任務推向數據產生的源頭,以減少延遲和帶寬壓力。

###

大數據處理不僅是技術層面的革新,更是驅動社會進步和產業升級的關鍵引擎。它要求我們不僅要掌握強大的技術工具,更要以負責任和戰略性的眼光,構建高效、可信、合規的數據處理體系,從而真正駕馭數據洪流,將信息轉化為智慧,賦能未來。